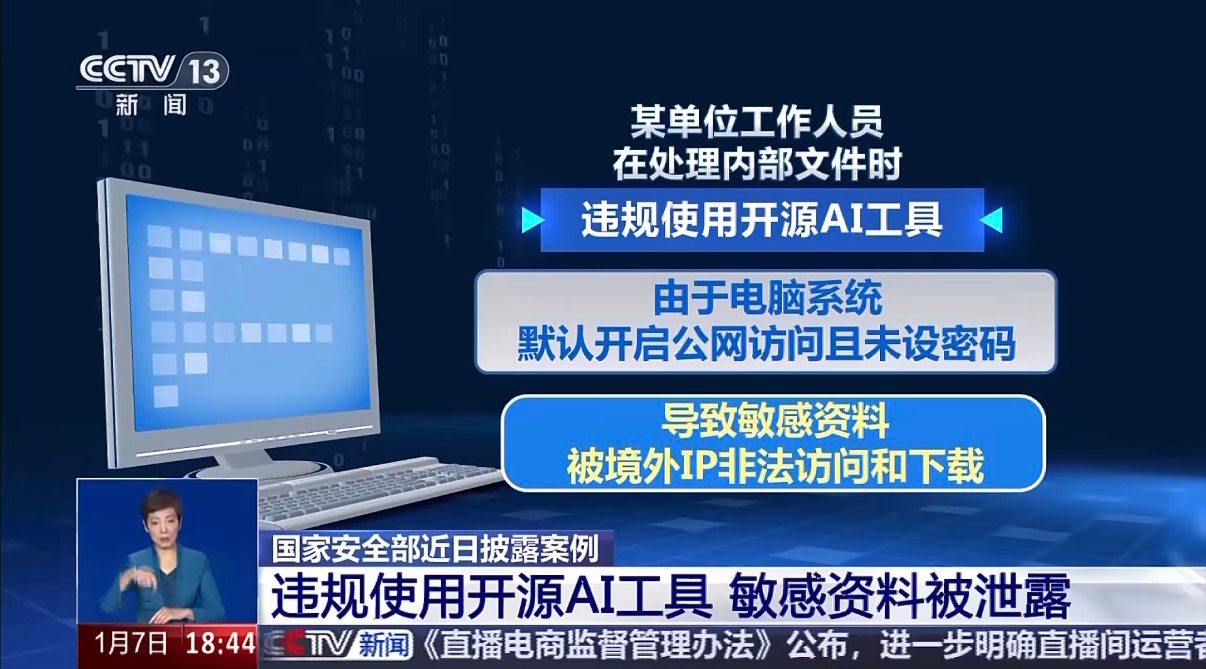

央视点名“AI 泄密”:企业如何安全使用 AI 工具?

这两天,一则央视报道把很多安全团队拉回现实:某单位工作人员在处理内部文件时,违规使用开源 AI 工具,又因为电脑系统默认开放公网访问且未设密码,最终导致敏感资料被境外 IP 非法访问与下载。

这不是“技术多高超”的故事,而是“流程没落地、工具没管住、行为没看见”的故事。

从 2025 年初 DeepSeek 爆火开始,企业对提效的渴望拉满——但安全侧也同步进入高压区:

- 业务要快:写文案、写代码、做分析、做会议纪要,最好“一键生成”;

- 安全要稳:核心数据不能出界、不能被训练、不能无法追溯;

- 管理要可控:不能靠“口头规定”和“员工自觉”。

一、AI 泄密为什么越来越常见?因为入口远不止“上传文件”

很多安全策略仍然只盯“文件上传”,但现实里,AI 泄密往往从四个入口同时发生:

1)网页/客户端上传:最直接,也最容易“误操作”

员工把合同、财务报表、研发材料上传给 AI 做总结、翻译或润色——文件离开企业边界的那一刻,风险就开始失控。尤其是开源工具、镜像站、小众客户端,安全能力与数据去向往往不透明。

2)对话框输入 + 复制粘贴:最隐蔽,也最容易被忽视

很多人不拖拽文件,而是从机密文档里复制一段关键内容,直接粘贴进 AI 对话框:看起来没有“外发文件”,但本质上数据已经出界。

3)浏览器插件:最“无感”,最容易越权采集

AI 摘要、阅读助手、翻译插件很便利,但一旦插件在你浏览内网、策略文档或机密资料时自动采集页面内容并上传处理,泄密就会发生在你毫无察觉的情况下。

4)开发者工具/中转站:对研发和企业最致命

AI 辅助编程工具(如 Copilot、Cursor 等)带来效率,也带来代码与凭据泄露的高风险:

- 核心代码片段、业务逻辑被上传

- API Key、连接串、配置文件随手带出

- 为绕过限制使用非官方 API 中转站,数据被记录、被滥用

这类风险一旦触发,影响的是知识产权与系统安全底座。

二、企业安全用 AI 的关键,不是封禁,而是“可控地用”

或许很多企业都走过两种极端:

- 全放开:效率高,但风险靠运气;

- 全封禁:风险压住了,但业务绕路、员工私用更多,反而更难管。

问题的本质不是“要不要用 AI 工具”,而是“企业能不能把数据带着规则去使用”。

薮猫科技在 AI 场景的数据防护上持续深耕,围绕企业最关心的“能用、可控、可追溯”,青骓 DDR(数据检测与响应系统)提供了一套可落地的闭环能力。

三、青骓 DDR:把“AI 提效”放进企业可控的安全边界里

面对 AI 时代的数据安全挑战,青骓 DDR 提供了全面的防护解决方案:

青骓 DDR 围绕“源头管控 + 分级响应 + 行为防护 + 插件管控+审计溯源”五步,把风险压下去、把效率升上去。

第一步:源头治理——高风险/非主流 AI 工具,直接“用不了”

最危险的往往不是大家都在用的主流工具,而是未经评估的开源站点、小众客户端、镜像服务。

青骓 DDR 管理后台支持对高风险或非主流 AI 工具的网页、App 进行禁用管理,从源头切断外泄可能。企业可设置允许访问的 AI 工具白名单,限制员工只能使用经过安全评估的 AI 服务。让“能不能用、用哪家、谁能用”回到企业可管理范围内,而不是靠自觉。

第二步:已认证的 AI 工具:让数据“带级别出门”,差异化防护

企业真正需要的不是“禁 AI”,而是“禁高敏数据出界”。

针对企业允许使用的 AI 应用,基于青骓 DDR 的智能数据分类分级能力,企业可以对不同重要等级的数据配置匹配的响应措施:

- L1(公开数据):允许上传至 AI 工具,提升效率;

- L5(高机密数据):如红头文件、设计图纸、核心经营材料等,可配置审批流程或直接阻断,确保数据不被随意上传。

并且,响应策略可按企业办公安全标准灵活配置,包括但不限于:阻断访问 / 审批后访问 / 弹窗警示等,做到“该放行就放行、该拦截就拦截”,安全与效率不再对立。

同时支持对 Word、PDF、图片等常见格式进行安全管理,并覆盖主流 AI 应用,支持用户新增应用纳管。

第三步:不止文件上传,键入/复制粘贴/截图同样可控

很多企业在管 AI 风险时,最容易只盯“文件上传/拖拽”,但员工真实的外发习惯远不止这一种:对话框键入、从文档复制粘贴核心内容、截图再上传,这些动作更碎、更隐蔽,也更常发生在“无意泄露”的场景里。

青骓 DDR 围绕 AI 使用的多类型数据外发路径,提供更完整的覆盖能力:

- 文件上传/拖拽:对 Word、PDF、图片等常见格式进行识别与分级响应;

- 内容审查:实时分析用户在网页中输入的内容,当系统检测到用户可能正在输入敏感信息时(无论是复制粘贴还是手动键入),及时弹出提醒,避免无意识泄密。

第四步:插件管控——消除“无感采集”的隐蔽泄密风险

很多企业在治理 AI 风险时,容易忽略浏览器插件——它不是“员工主动上传”,而是可能在你毫无察觉时读取页面内容并外发处理。尤其当员工浏览企业内网、知识库、邮件系统或机密文档时,某些 AI 摘要/翻译/阅读助手插件可能自动抓取页面文本,成为最隐蔽的数据外泄通道。

青骓 DDR 针对这一类风险提供专门的插件管控能力:

- 只允许企业认可的插件安装与运行,未授权或高风险插件可直接拦截;

- 对插件相关行为进行审计与告警,让“谁装了什么、何时启用、是否触达敏感页面”变得可见、可追溯;

- 与数据分级策略联动:当插件触达高敏数据场景时,可触发相应的阻断/告警策略,降低“无意泄密”。

员工未必在“发”,插件可能在“拿”。把插件纳管,才能补齐 AI 风险治理最容易漏掉的一块。

第五步:可视化审计——把“追责与合规”从口头,变成证据链

AI 使用常态化后,管理层最需要的是确定性:

- 到底有没有人把敏感数据喂给外部 AI?

- 谁做的?什么时候做的?通过什么方式?发给了哪款 AI?

- 发出的内容是否涉及高敏感信息?

青骓 DDR 通过全生命周期数据检测技术,记录数据的动态(生成、复制、流转、外发等),并全面记录员工与数据的交互行为,形成可视化安全审计与合规支撑。

用一句话总结就是:谁在何时以何种方式把哪些数据发给了哪款 AI 工具——你查得到,也说得清。

四、给安全团队 / CIO / 老板的落地建议:先立“三条红线”

企业要把 AI 用起来,同时把风险压下去,建议先落地三条红线:

1)工具先纳管:高风险 AI 工具先禁用,允许使用的进入清单化管理;

2)数据先分级:L1 放行提升效率,L5 必须拦截或审批;

3)行为要覆盖:不仅管上传,更要管键入、复制粘贴、截图等隐形外发;并且全程可审计。

AI 时代的数据安全,不靠喊口号,不靠培训“自觉”,靠的是规则可执行、策略可落地、过程可追溯。

结语:AI 时代的数据安全,不是“堵”,而是“可控地用”

真正成熟的企业,不会在“全放开”和“全封禁”之间摇摆,而是用数据分级与响应策略,把效率和安全同时拉起来。

如果你和你的企业也在推动内部 AI 工具使用、同时被“合规/追溯/外泄风险”困扰,青骓 DDR 可以从禁用纳管、分级策略、剪贴板防护、可视化审计四个维度,真正帮助企业把这件事做成“能落地、可持续”的体系。

欢迎联系我们,获得专属行业数据安全解决方案,和薮猫科技一起,解锁更多数据安全防护新体验!

-END-